Inhaltsverzeichnis

Inhaltsverzeichnis

Kurzbeschreibung

Funktionen

Nutze ChatGPT, Microsoft Azure OpenAI, einen selbstgehosteten Dienst oder einen anderen Dienst, welcher die ChatGPT API Definition verwendet.

Nutze ein Large Language Model um unterschiedliche Aufgaben der Textverarbeitung zu automatisieren.

Ideal für den Einsatz im Layoutdesigner oder innerhalb von Workflows.

Dokumentation

Komplexität der Implementation

Zeitaufwand der Implementation / Konfiguration

Voraussetzungen

Das AI Toolkit ist eine Erweiterung für das Matrix42 Workspace Management. Es bietet eine Sammlung an Workflow Activities und konfigurierbaren AI Funktionen welche mit OpenAI kommunizieren. Dies kann mit Azure OpenAI oder anderer kompatiblen Software erfolgen.

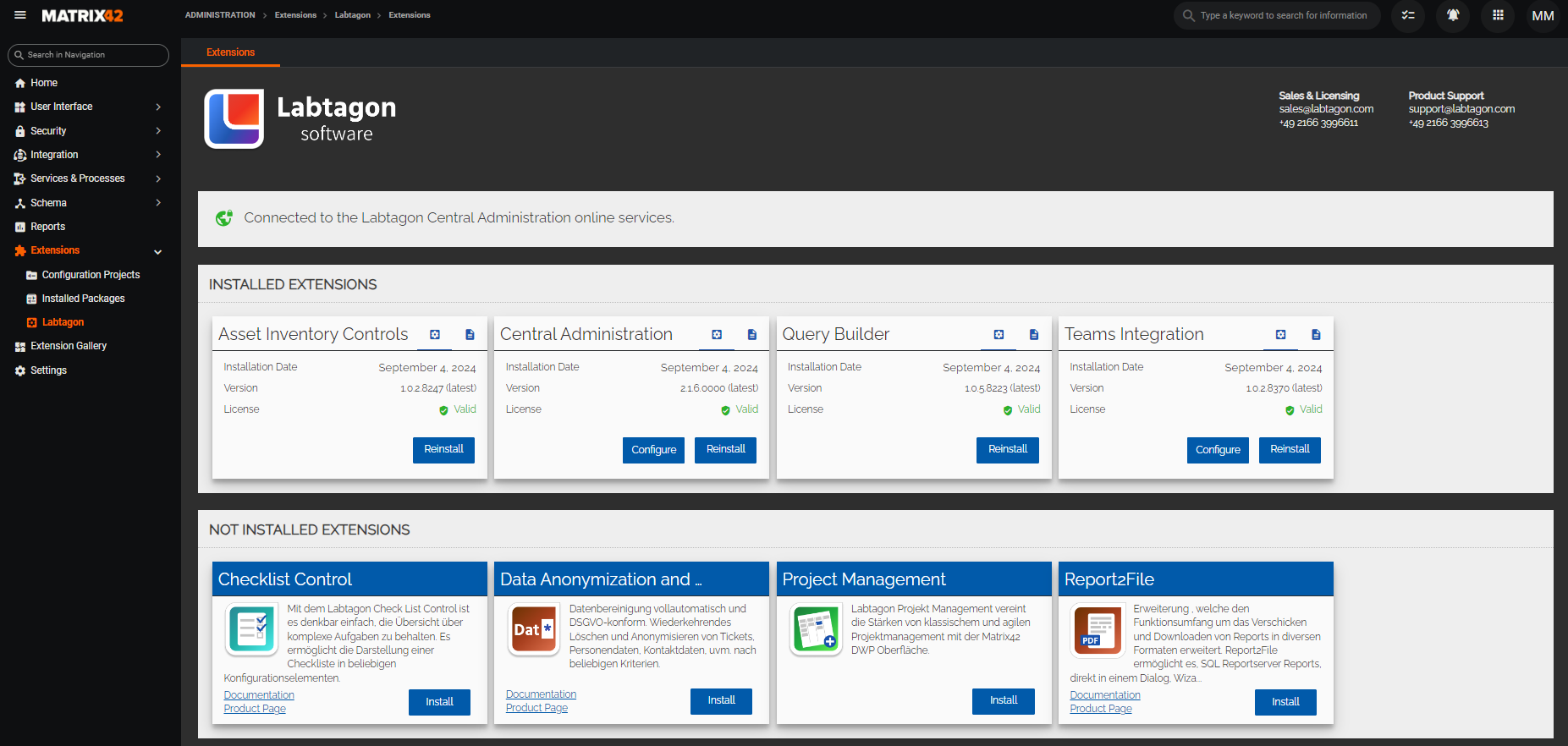

Installation mit Central Administration

Erweiterungen von Labtagon lassen sich denkbar einfach installieren. Lade dir dafür die Central Administration herunter und folge der Installationsanleitung zur Einrichtung des Tools. Mit der Central Administration lässt sich dann die gekaufte Erweiterung per Knopfdruck installieren.

Schnellstart

Service Konfigurationen

Die Service Konfigurationen finden Sie im AI Toolkit Dialog. Klicken Sie in der Administration unter Erweiterungen > Labtagon auf den Button “Konfigurieren” des AI Toolkits, um den Dialog zu öffnen. In einer Service Konfiguration können Sie einen Namen und eine Beschreibung hinterlegen, um diese zu dokumentieren. Des Weiteren können Sie einen API Key und einen Typ hinterlegen. Jede Service Konfiguration benötigt einen API Key. Abhängig vom Typ der Service Konfiguration, wird der API Key anderweitig erstellt. Wie Sie einen API Key für OpenAI erstellen können, können Sie im oberen Abschnitt “OpenAI API Key Erstellen” nachlesen. Basierend auf den Typ, ändert sich die Konfiguration: OpenAI:

- Für OpenAI benötigen Sie nur den API Key.

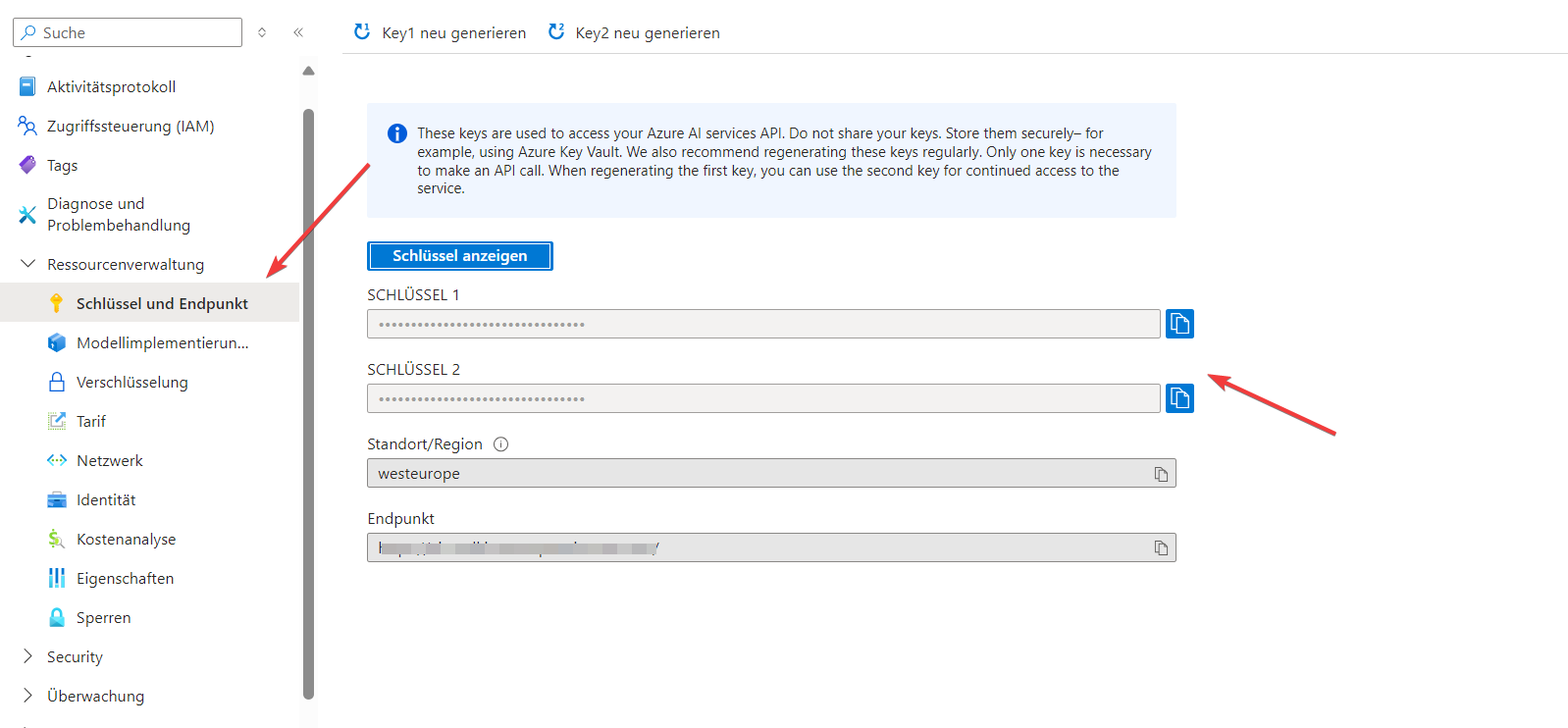

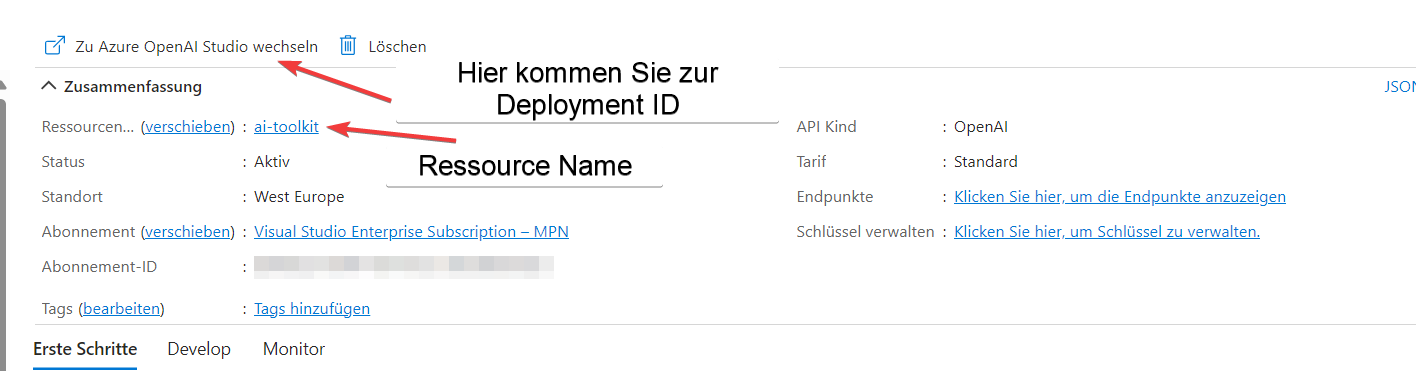

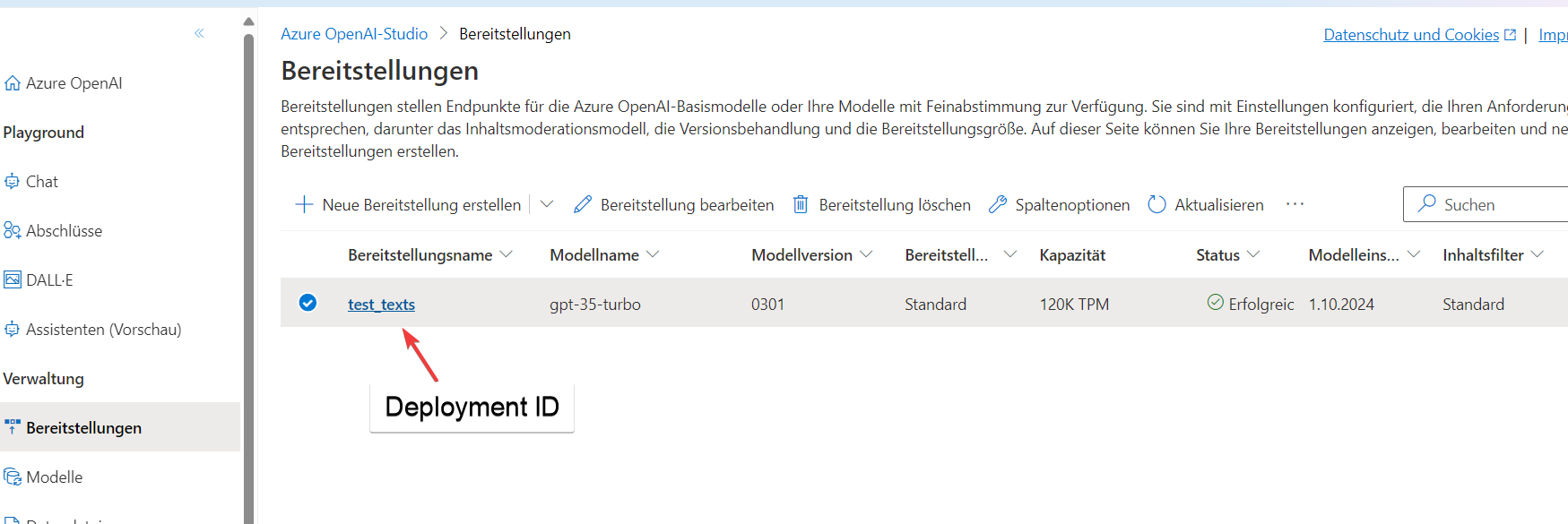

- Hier werden die folgenden Informationen aus Ihrer erstellten Azure-Ressource benötigt (für Informationen über die Ersellung lesen sie "Azure OpenAI Service Konfiguration"):

-

- API-Version

- Ressource Name (Ressourcenname)

- Deployment ID (Bereitstellungsname)

- API Key (einer der beiden generierten Keys)

- ChatGPT-kompatible Dienste benötigen den API Key und die Service Adresse.

AI Funktionen

Die AI Funktionen finden Sie in dem Konfigurationsdialog des AI Toolkits. Klicken Sie dazu auf den Button “Konfigurieren” des AI Toolkits unter Erweiterungen > Labtagon. In dem Konfigurationsdialog können Sie die AI Funktionen erstellen und bearbeiten.

Labtagon AI Toolkit definiert AI Funktionen als Vorlagen für Prompts an das Large Language Model (LLM).

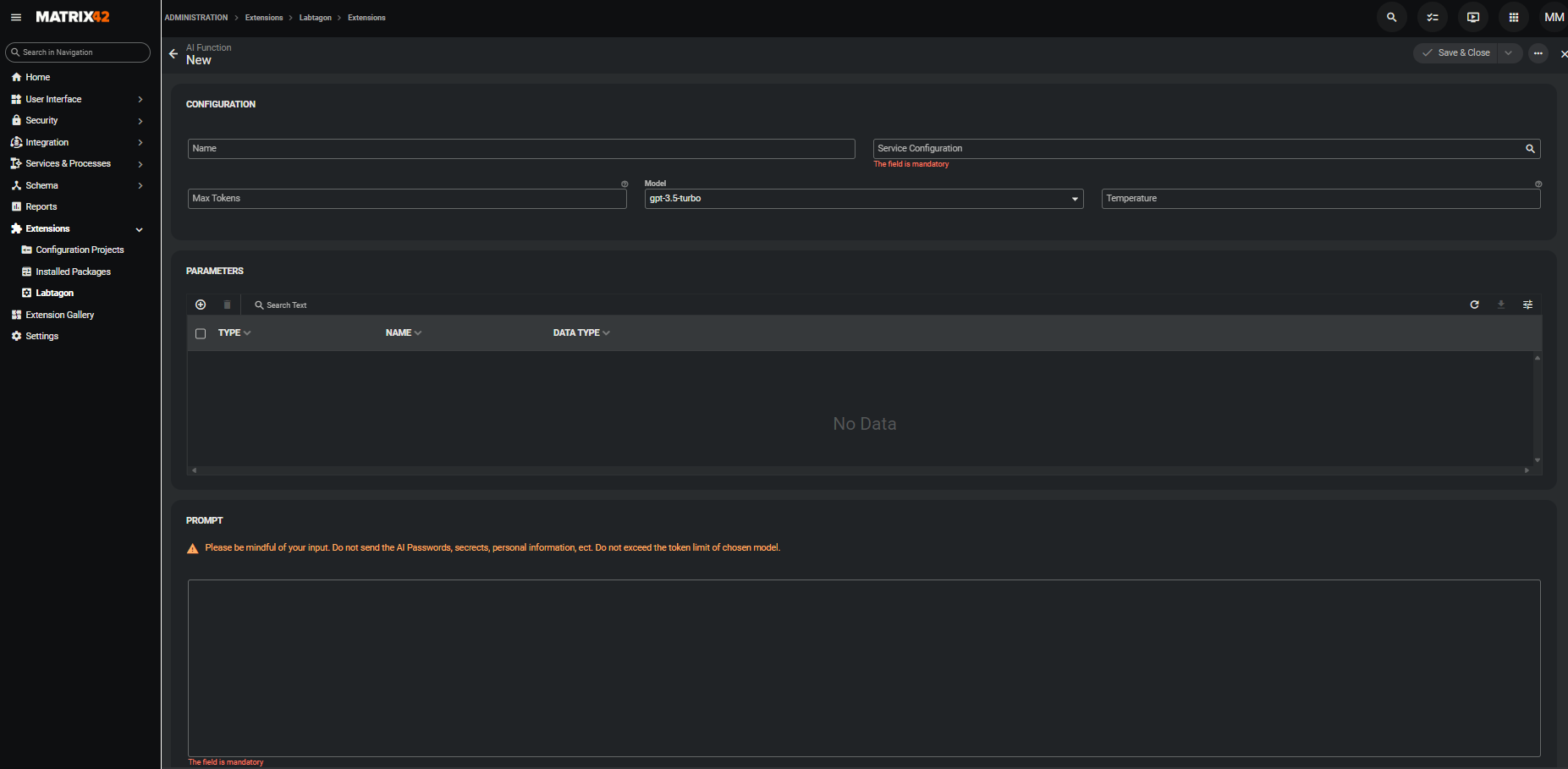

Sobald Sie eine Service Konfiguration zu einem LLM-Anbieter eingerichtet haben, können Sie AI Funktionen definieren. Klicken Sie dazu im AI Toolkit Dialog auf das “+” unter AI FunktionenIm Anschluss öffnet sich der AI Funktionsdialog.

Konfiguration

Setzen Sie den Namen der Funktion und wählen Sie eine Service Konfiguration aus. Außerdem können Sie folgende Parameter festlegen:

- Maximale Anzahl der Ausgabe-Tokens (optional): Die Ausgabe Tokens sind Teile von Worten, sie sind eine bestimmte Anzahl von Zeichen. Eine genauere Definition von Tokens finden Sie unter What are tokens and how to count them? | OpenAI Help Center. Dieser Parameter begrenzet die Anzahl der Tokens in der Antwort des LLM.

- Modell: Das Modell der AI, dass Ihre Antwort generiert. Weitere Informationen zu den verschiedenen Modellen finden sie hier: Models - OpenAI API. Das Modell gpt-3.5-turbo kann inkonsistent sein.

- Temperatur (optional): Bestimmt die Zufälligkeit der Antwort. Temperatur ist standardmäßig auf 1 gesetzt. Es ist eine Dezimalzahl zwischen 0 und 2. Bei 2 ist die Antwort am zufälligsten.

Parameter

Sie können im Prompt mit einem „@“ einen Input Parameter einfügen, welcher später mit dem gewünschten Wert befüllt wird. Output Parameter werden im Gegensatz zu den Input Parametern nicht im Prompt genutzt.

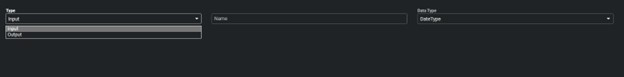

Es gibt zwei Arten von Parametern:

- Input-Parameter:

- Die Input Parameter können im Prompt genutzt werden, indem Sie “@” und danach den Parameternamen einfügen. An dieser Stelle wird der Platzhalter mit dem gewünschten Wert des Nutzers ersetzt.

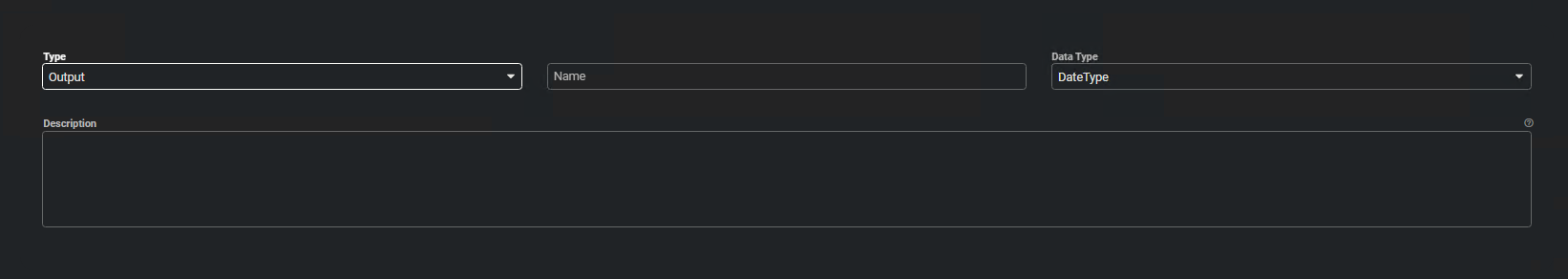

- Output-Parameter:

- Bei Output Parameter muss eine Beschreibung gesetzt werden, damit die AI die Parameter nach Ihren Vorgaben setzen kann.

- Das LLM wird angewiesen seine Ausgabe in definierten Parametern durchzuführen.

Prompt

Der Prompt wird mit einer Beschreibung der gewünschten Funktion versehen, welche die AI erfüllen soll. Dieser sollte so genau wie möglich erklärt sein und es müssen alle Informationen enthalten sein, die das LLM braucht.

Im Prompt können die Input-Parameter eingebettet werden. Die Syntax fürs Einbetten eines Input Parameters lautet @Parametername. Für weitere Informationen über das Erstellen von Parametern, wenden Sie sich an den obigen Abschnitt.

Sie können außerdem dynamisch Daten in ihrem Prompt ersetzen. Mit Hilfe einer Syntax zum Einbetten einer ASQL Abfrage, werden die Daten, bevor der Prompt an die AI geschickt wird, geholt und im Platzhalter des Prompts ersetzt. So haben Sie zum Beispiel die Möglichkeit die vorhandenen Ticket Kategorien mitzugeben.

Die Syntax für das Einbetten einer ASQL-Abfrage lautet:

[Tabellenname, Spaltenausdruck, Filterausdruck]

Beispiel:

[SPSUserClassBase, "FirstName, LastName", "Name <> 'Max'"]

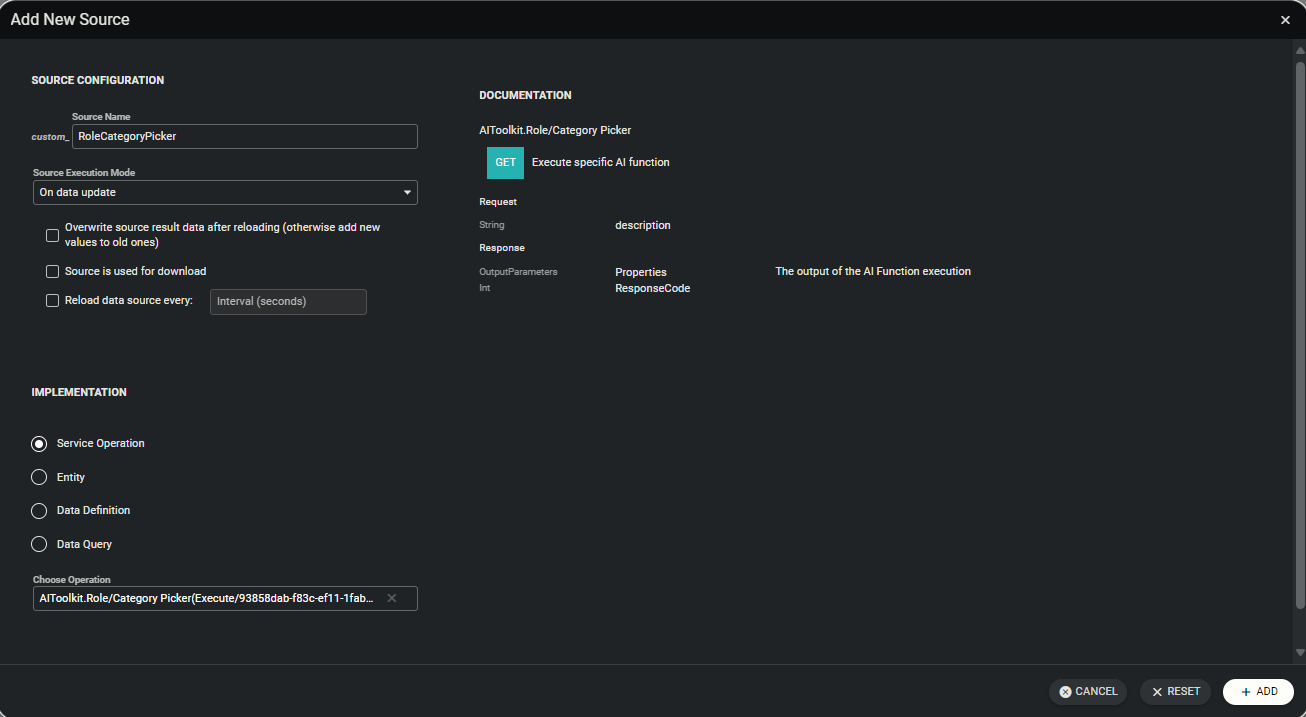

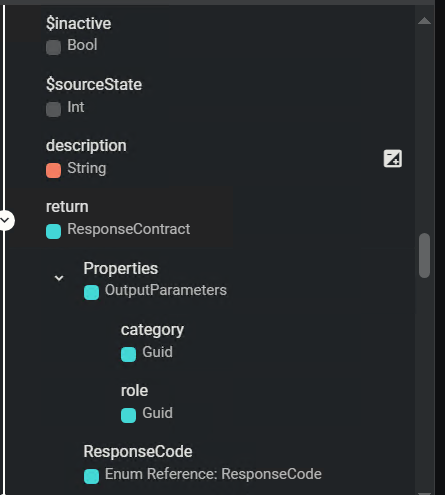

Nutzung einer AI Funktion

Sobald eine AI Funktion gespeichert wird, wird zusätzlich eine gleichnamige Webserviceoperation angelegt. Diese Webserviceoperation können Sie im Layout Designer als Datenquelle hinzufügen, um diese in Ihrer Ansicht auszuführen.

Konfiguration

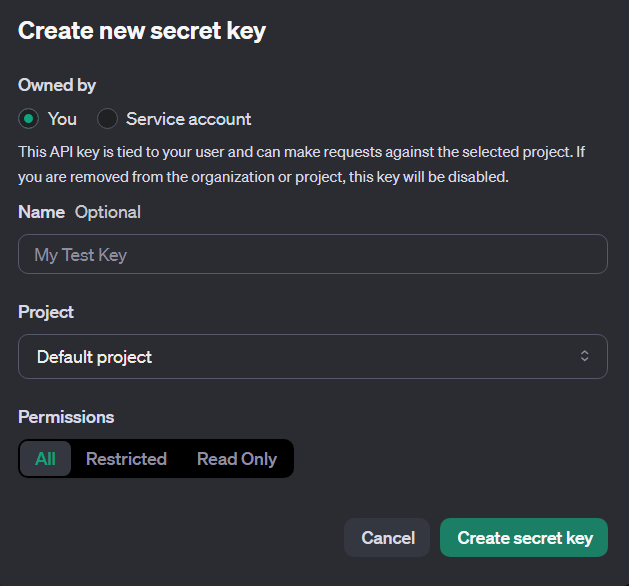

OpenAI API Key Erstellen

Um OpenAI im AI Toolkit zu nutzen, benötigen Sie einen API Key. Gehen Sie dazu auf die Website OpenAI Platform, um einen API-Key zu erstellen.

Achten Sie beim Erstellen darauf den API Key in einer Notiz o.Ä. zu speichern, da dieser nach Schließen des Pop-Ups nicht erneut ausgelesen werden kann.

Azure OpenAI Service Konfiguration

Um eine Azure OpenAI Service Konfiguration verwenden zu können, benötigen Sie eine Azure Ressource.

Wie Sie eine Azure Ressource erstellen, können Sie im folgenden Guide nachlesen: How-to: Create and deploy an Azure OpenAI Service resource - Azure OpenAI | Microsoft Learn.

Umfang der Lieferung

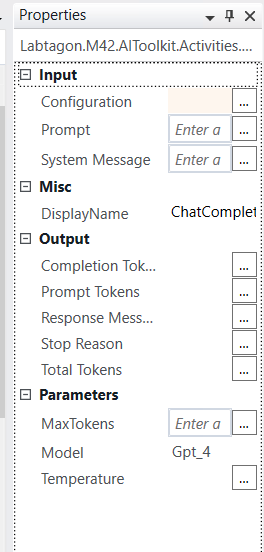

Chat CompletionWorkflow Activity

Die AI kann auf Nutzereingaben reagieren und menschenähnliche Antworten zurückgeben.

Input:

- Configuration: Wählen Sie die gewünschte AI Service Konfiguration aus.

- Parameter: Definieren Sie die Parameter in Ihrem Prompt. „Name“ ist der Parametername und die Expression kann entweder mit einer Variable oder einer Typ-Expression gestaltet werden.

- MaxTokens: Die Ausgabe Tokens sind Teile von Worten, sie sind eine bestimmte Anzahl von Zeichen. Eine genauere Definition von Tokens finden Sie unter What are tokens and how to count them? | OpenAI Help Center. Dieser Parameter begrenzet die Anzahl der Tokens in der Antwort des LLM.

- Prompt: Nachricht an die AI, welche beantwortet werden soll.

- System Message: System Message dient dazu der AI Anweisungen zu geben. Die System Message ist nicht mit dem Prompt gleich zu setzen. Eine Beispiel System Message wäre: „you are a helpful assistant“.

- Temperature: Bestimmt die Zufälligkeit der Antwort. Temperatur ist standardmäßig auf 1 gesetzt. Es ist eine Dezimalzahl zwischen 0 und 2 sein. Bei 2 ist die Antwort am zufälligsten.

Output:

- Completion Tokens: Die Anzahl der Tokens, welche die Antwort verbrauchte.

- Prompt Tokens: Die Anzahl der Tokens, die in der Abfrage verbraucht wurden.

- Stop Reason: Der Grund, warum die AI die Antwort abgebrochen hat.

- Total Tokens: Die insgesamt verwendete Anzahl der Tokens.

- Response Message: Die Generierte Antwort.

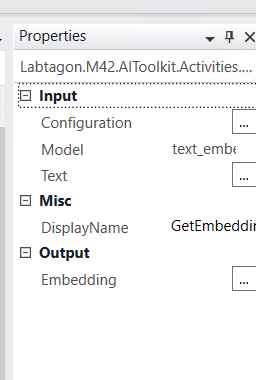

Get EmbeddingsWorkflow Activity

Gibt die Koordinaten der Eingabe in der AI wieder.

Input:

- Configuration: Wählen Sie die gewünschte AI Service Konfiguration aus.

- Text: Text, von dem die Embeddings geholt werden sollen.

Output:

- Embedding: Ausgabe vom Typ float[]. Embeddings sind die Koordinaten der Eingabe in dem LLM insgesamt sind es 1536 Koordinaten.

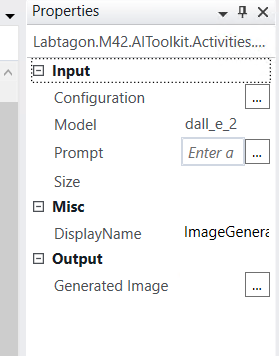

Image GenerationWorkflow Activity

Generiert ein Bild basierend auf der Eingabe des Nutzers.

Input:

- Prompt: Die Beschreibung des zu generierenden Bildes.

- Configuration: Wählen Sie die gewünschten AI Service Konfiguration aus.

- Size: Die Größe des Bildes (256x256, 512x512 oder 1024x1024).

Output:

- Generated Image: Das generierte Bild als Byte Array.

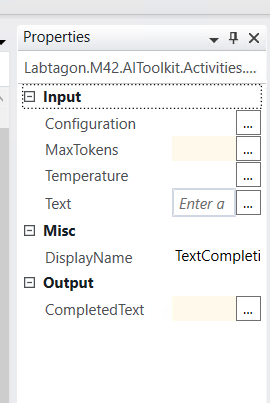

Text CompletionWorkflow Activity

Die Workflow Activity kann Texte basierend auf Nutzereingaben generieren oder vervollständigen.

Input:

- Model: Das GPT-Modell, welches für die Vervollständigung genutzt werden soll. Für näheres schauen Sie sich die Modelle unter diesem Link an: Models - OpenAI API.

- Prompt: Prompt ist der Text, welcher beendet oder vervollständigt werden soll.

- Configuration: Wählen Sie die gewünschte AI Service Konfiguration aus.

Output:

- Completed Text: Der generierte oder vervollständigte Text.

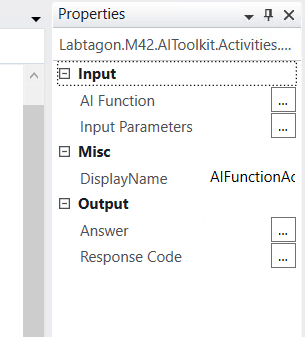

AI FunktionWorkflow Activity

Mit dieser Workflow Activity können Sie die AI Funktionen in Ihrem Workflow nutzen. Input:

- AI Funktion: Die ausgewählte AI Funktion.

- Input Parameter: Die ausgefüllten Parameter

- Answer: Die generierte Antwort auf dem Prompt der AI Funktion.

- Response Code: Der Code der Antwort, basierend auf den Zusand.

Weitere Dokumente

Central Administration

Das Tor in die Welt der Erweiterungen von Labtagon

Die Labtagon Central Administration ist die Kernkomponente unserer Erweiterungen für das Matrix42 Workspace Management. Über die Central Administration können Erweiterungen konfiguriert, Lizenzen abgerufen und darüber hinaus Updates installiert werden.

Standard Support

für Matrix42 Workspace Management

Wir unterstützen alle Standard Support & LTSB Versionen, und für Cloud-Kunden auch die Technical Release Versionen. Sobald Matrix42 die Unterstützung für eine Version abgekündigt hat stellen auch wir die Unterstützung für Erweiterungen in dieser Version ein.

Weitere Informationen über aktuell unterstützte Versionen der Matrix42 finden sie in der Matrix42 Knowledgebase.

Wichtiger Hinweis

Die Installation einer inkompatiblen Version könnte fehlschlagen. Diese Pakete funktionieren ausschließlich mit der entsprechenden Matrix42 Workspace Management Version. Falls Sie Probleme bei der Installation haben, zögern Sie nicht, unseren Support zu kontaktieren.

Nehme Kontakt zu uns auf

Damit es schnell geht und keine Unzufriedenheit bei den Anwendern oder Kunden entsteht, helfen wir Ihnen, das Problem zu finden und zu lösen.

Gerne senden wir dir ein unverbindliches Angebot zu.

Möchtest du dich noch näher mit dem Produkt auseinandersetzen bieten wir auch an, einen gemeinsamen Termin für eine Livepräsentation oder für ein Webinar zu vereinbaren.

Nutze dafür einfach das Kontaktformular oder ruf uns an.